Elon Musk, consejero delegado de Tesla, Steve Wozniak, cofundador de Apple, y el escritor y politólogo Yuval Noah Harari han firmado una carta abierta en la que se pide una pausa de seis meses en los «gigantescos experimentos de inteligencia artificial» y se aboga por una moratoria de seis meses para dar tiempo a las empresas de inteligencia artificial y a los reguladores a formular salvaguardas para proteger a la sociedad de los riesgos potenciales de la tecnología.

Elon Musk, consejero delegado de Tesla, Steve Wozniak, cofundador de Apple, y el escritor y politólogo Yuval Noah Harari han firmado una carta abierta en la que se pide una pausa de seis meses en los «gigantescos experimentos de inteligencia artificial» y se aboga por una moratoria de seis meses para dar tiempo a las empresas de inteligencia artificial y a los reguladores a formular salvaguardas para proteger a la sociedad de los riesgos potenciales de la tecnología.

En la década de 1940, los investigadores y científicos de lo que más tarde se conocería como «inteligencia artificial» empezaron a juguetear con una idea tentadora: ¿Y si los sistemas informáticos se diseñaran como el cerebro humano? El cerebro humano está formado por neuronas, que envían señales a otras neuronas a través de sinapsis conectivas formando un circuito neuronal. La fuerza de estas conexiones neuronales puede aumentar o disminuir con el tiempo. Las conexiones que se usan con frecuencia se fortalecen y las que se descuidan se desvanecen. Juntas, estas conexiones forman nuestros juicios e instintos y nuestro verdadero yo. En 1958, Frank Rosenblatt sacó un concepto de cerebro simplificado, entrenado para reconocer patrones y reproducirse en cadenas de montaje. Rosenblatt no fracasó; simplemente fue precoz y se adelantó mucho a su tiempo.

Esta técnica ahora llamada «aprendizaje profundo» empezó a superar significativamente a otros enfoques, de visión por ordenador, precisión, predicción, traducción y similares. La IA basada en redes neuronales ha ido aplastando a las fuerzas competidoras contemporáneas en todos los demás campos, incluida la visión por ordenador, la traducción, los videojuegos e incluso el ajedrez. Los sistemas de aprendizaje automático se han vuelto muy competentes y los investigadores afirman que son «escalables». El término «escalable» se refiere al hecho de que cuanto más dinero y datos se introducen en la red neuronal, más crece, más tiempo dedica al entrenamiento, más datos aprovecha y mejor funciona. A pesar de que las grandes empresas tecnológicas realizan ahora carreras multimillonarias para sus sistemas, nadie se ha acercado a darse cuenta de los límites y riesgos potenciales de este principio.

Ray Kurzweil, uno de los futuristas inminentes, profetizó que los ordenadores tendrán el mismo nivel de inteligencia que los humanos en 2029. Afirma: «2029 es la fecha que he predicho para cuando una IA supere una prueba de Turing válida y, por tanto, alcance niveles humanos de inteligencia. He fijado la fecha de 2045 para la ‘Singularidad’, que es cuando multiplicaremos nuestra inteligencia efectiva por mil millones al fusionarnos con la inteligencia que hemos creado». La IA mejorará la situación de la mayoría de las personas gracias a avances tecnológicos sin precedentes, pero también afectará en gran medida a lo que realmente significa ser humano en el siglo XXI.

Es indudable que el futuro de la IA tiene algunos aspectos positivos, como la medicina de precisión, que puede mejorar la genética de una persona, y el diagnóstico con más precisión para tratar enfermedades y hacer que los tratamientos sean más fáciles, accesibles y asequibles. Asistentes virtuales como Siri, Alexa y otros programas están haciendo que las actividades mundanas de los humanos sean más sencillas, contribuyendo a un estilo de vida más relajado. Programas como Chat GPT ayudan a procesar sus datos y su lenguaje respondiendo a preguntas de forma similar a la humana y resolviendo cuestiones complejas sobre diversos temas.

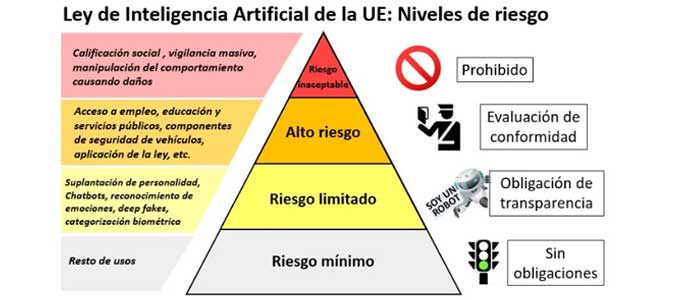

El lado oscuro de la IA inculca ciertos riesgos inevitables que giran en torno a la forma en que se están usando la IA y sus mecanismos, incluida la vigilancia masiva, el abuso de sus datos y la destrucción de la privacidad digital. Esta vigilancia digital ya está en marcha en el sistema de crédito social de China, que extiende la vigilancia a todos los aspectos de la vida de los ciudadanos. La guerra moderna, impulsada por técnicas automatizadas, es otra gran preocupación, ya que la supremacía bélica vendrá dictada por los avances tecnológicos. Una de las mayores preocupaciones relacionadas con el auge de la IA es su capacidad para reemplazar los puestos de trabajo humanos y, con el tiempo, la competencia humana en el panorama socioeconómico. La eficiencia y precisión de los modelos de aprendizaje automático pueden superar fácilmente a la inteligencia humana, ampliando las desigualdades económicas, los trastornos sociales y las revueltas populistas.

Los avances tecnológicos en IA han galopado desde la invención de software como Chat GPT, de la empresa OpenAI, respaldada por Microsoft, y la compañía ha lanzado recientemente Chat GPT y GPT-4, dos chatbots generadores de texto, que están causando furor entre ciertos especialistas en Inteligencia Artificial. Los aparentemente inofensivos chatbots se basan en la capacidad «generativa» de imitar respuestas similares a las humanas, combinada con la velocidad de adopción y adaptabilidad, lo que ha pillado desprevenidos a muchos, ya que los principales gigantes tecnológicos de todo el mundo se apresuran a incorporar la IA generativa a sus productos. Científicos, investigadores y directores ejecutivos de empresas tecnológicas se han dado cuenta de esta alarmante situación. Se ha pedido una carta abierta en la que se insiste en la necesidad de hacer una pausa de 6 meses en los «experimentos gigantescos de IA» y que cuenta con las firmas de Elon Musk, consejero delegado de Tesla; Steve Wozniak, cofundador de Apple; Yuval Noah Harari, autor y politólogo; Jaan Tallinn, cofundador de Skype; Andrew Yang, político, y muchos otros.

La carta abierta afirma que la actual dinámica de carrera de la Inteligencia Artificial es peligrosa, ya que los laboratorios de IA están atrapados en una carrera fuera de control para desarrollar y desplegar sistemas de aprendizaje que nadie, ni siquiera los creadores, puede entender, predecir o controlar. Aboga por una moratoria de 6 meses para dar tiempo a las empresas de IA y a los reguladores a formular salvaguardas para proteger a la sociedad de los riesgos potenciales de la tecnología. «Esta pausa debe ser pública y verificable, incluyendo a todos los actores clave. Si esta pausa no puede aplicarse rápidamente, los gobiernos deberían intervenir e instituir una moratoria», se afirma en la carta abierta. Una amenaza potencial que surge de los sistemas de IA es la del abuso de datos y los motores de desinformación, que violan la privacidad de los datos, engañan a la gente con información fabricada y perpetúan el sesgo sistémico en la información que acaba llegando a la gente.

La maravilla de estos modelos y software de IA no es propia de ellos, sino que se sustenta y se construye sobre la base del trabajo de trabajadores que se esfuerzan en malas condiciones para etiquetar y entrenar estos sistemas. Al parecer, una investigación de TIME ha descubierto que OpenAI, creadora de Chat GPT, empleó mano de obra subcontratada de Kenia que ganaba menos de 2 dólares por hora, en la búsqueda de hacer Chat GPT menos tóxico.

Algunos tecnólogos han advertido de amenazas de seguridad más profundas. Estos asistentes digitales que interactúan con la web, leen y escriben correos electrónicos podrían ofrecer nuevas oportunidades a los piratas informáticos y poner en peligro toneladas de información personal, así como secretos de Estado confidenciales. A los piratas informáticos les resultaría fácil manipular y explotar el software para intentar acceder a los datos almacenados en ellos, ya que los programas de IA carecen de protocolos de salvaguardia adecuados.

No hay límites para los logros que puede alcanzar el ingenio humano. La Inteligencia Artificial es uno de esos inventos que podría ser, y probablemente sea, insondablemente destructivo. Es alarmantemente peligrosa porque podría llegar el día en que dejara de estar bajo nuestro control, ya que carecen de conciencia humana y podrían hacer algo no alineado con los objetivos humanos, o suponer una amenaza existencial. Puede parecer extraño, dado lo que está en juego, que se haya dejado que la industria se autorregule. No es legal que las empresas tecnológicas construyan armas nucleares por su cuenta, y sin embargo los gigantes tecnológicos se encuentran en una dinámica similar a una carrera para desarrollar sistemas que ellos mismos reconocen que probablemente llegarán a ser más peligrosos que las propias armas nucleares. El progreso de la IA ha sido extraordinariamente rápido, dejando a los reguladores a la zaga, sin prestar apenas atención a las normas de seguridad de estos sistemas de IA.

Sólo el tiempo dirá si los avances de la IA en los próximos años resultarán ser una panacea para los problemas mundiales, o un monstruo de Frankenstein que amenaza la existencia de la humanidad, temerosa de su propia creación de la que no sabe nada.

Fte. Modern Diplomacy (Rameen Siddiqui)

Rameen Siddiqui es un joven líder y aspirante a activista. Sus principales áreas de interés son la geopolítica, la historia, la actualidad y la economía. También es miembro del Executive Council of Young Peace and Development Corps (YPDC) Greenwich chapter, Government of Pakistan. Es licenciada en Economía y Finanzas por la Universidad de Greenwich.