La Fuerza Aérea de EE.UU. se está preparando para combatir contra robots enemigos dotados de IA debido al rápido crecimiento y la implementación de esta por parte de naciones rivales, si bien sigue centrándose intensamente en aprovechar sus aplicaciones efectivas y «éticas».

La Fuerza Aérea de EE.UU. se está preparando para combatir contra robots enemigos dotados de IA debido al rápido crecimiento y la implementación de esta por parte de naciones rivales, si bien sigue centrándose intensamente en aprovechar sus aplicaciones efectivas y «éticas».

En su reciente intervención en el Foro de Defensa Reagan en Washington, DC, el Secretario de la Fuerza Aérea, Frank Kendall, dejó claro que ésta se mueve rápidamente para aprovechar los efectos de cambio de paradigma de la IA y su impacto en los sistemas de armas, mando y control, procesamiento de datos, selección de objetivos, identificación de amenazas y redes. Al mismo tiempo, Kendall dejó claro que es necesario comprender y consolidar más la integración de la IA en determinadas áreas y que los parámetros éticos se tendrán muy en cuenta en cualquier decisión relativa a la aplicación de armas, autonomía y sistemas basados en IA. Sin embargo, Kendall también afirmó que naciones rivales como China están reduciendo rápidamente el margen de superioridad que ahora presentan los sistemas de IA estadounidenses, y que los adversarios potenciales pueden no estar dispuestos a considerar ningún tipo de restricción ética en el uso de la fuerza autónoma posibilitada por la IA.

«Me preocupan mucho la sociedad civil y el derecho en los conflictos armados», declaró Kendall, citado en un ensayo de las Fuerzas Aéreas. «Nuestras políticas se basan en esas leyes. Las leyes no se aplican a las máquinas, sino a las personas. Nuestro reto no es limitar lo que podemos hacer con la IA, sino encontrar la forma de responsabilizar a las personas de lo que hace la IA. La forma en que deberíamos enfocarlo es averiguar cómo aplicar las leyes de los conflictos armados a las aplicaciones de la IA. A quién hacemos responsable del funcionamiento de esa IA y qué exigimos a las instituciones antes de desplegar este tipo de capacidades y emplearlas operativamente».

Durante años, la doctrina del Pentágono ha ordenado que cualquier decisión relativa al uso de la fuerza letal debe ser tomada por un ser humano, sin embargo, los desarrolladores de armas de vanguardia hacen hincapié en que el procesamiento de datos y la orientación de alta velocidad habilitados por la IA pueden mejorar drásticamente la velocidad y la eficiencia de la toma de decisiones humana.

«Nuestro trabajo en el ámbito gubernamental, más que cualquier otra cosa, es comprender a fondo esta tecnología, tener la experiencia que necesitamos para entrar realmente en los detalles de la misma y apreciar cómo funciona», dijo Kendall. «Ser creativos a la hora de ayudar a la industria a encontrar nuevas aplicaciones para esa tecnología y desarrollar formas de evaluarla para conseguir la confianza que vamos a necesitar para garantizar que pueda emplearse de forma ética y fiable cuando esté en manos de nuestros combatientes».

IA – Guerra a la velocidad de la relevancia

La capacidad de un sistema totalmente autónomo para rastrear, identificar y destruir un objetivo sin intervención humana está prácticamente aquí, pero este tipo de operaciones están restringidas por los dirigentes estadounidenses y del Pentágono, que explican que la velocidad y las ventajas de la IA pueden seguir beneficiando enormemente a los mandos, al tiempo que garantizan que los ataques con fuerza letal son decididos por responsables humanos. No obstante, aunque esta doctrina aún puede mantenerse, Kendall también indicó que «no usar» la IA puede traducirse rápidamente en perder en combate. La velocidad de procesamiento y ciertos tipos de organización y análisis de datos son «exponencialmente» más rápidos cuando los permite la IA.

«El parámetro crítico en el campo de batalla es el tiempo», dijo Kendall. «La IA podrá hacer cosas mucho más complicadas con mucha más precisión y mucha más rapidez que los seres humanos. Si el humano está en el control perderá. Puedes tener supervisión humana y vigilar lo que hace la IA, pero si intentas intervenir vas a perder. La diferencia clave es cuánto tarda una persona en hacer algo y cuánto tarda la IA».

La referencia de Kendall al tiempo parece totalmente exacta y precisa con respecto a lo que todos los ejércitos están haciendo ahora con el tiempo que va de «sensor» a «tirador». Mandos de la Fuerza Aérea como el ex Comandante de la Fuerza Aérea de EE.UU. en Europa, General Jeffrey Harrigian, hablaron de posibilitar la toma de decisiones críticas en los límites del combate y aprovechar los beneficios de la IA para combatir a la «velocidad de la relevancia». Operaciones como la organización de los datos de los sensores, la búsqueda y verificación de objetivos de gran valor y el bloqueo de determinados elementos de la puntería pueden mejorarse enormemente gracias a la IA.

Dado que los humanos no pueden replicar la velocidad analítica y de procesamiento de los ordenadores con capacidad de IA, y que los sistemas potenciados por la IA no pueden replicar los muchos matices más subjetivos, pero impactantes, de la cognición humana, cualquier camino óptimo hacia el futuro parece sugerir la integración o combinación de ambos.

«Creo que el futuro pasa por el trabajo en equipo entre el hombre y la máquina», afirmó el General David Allvin, Jefe del Estado Mayor del Ejército del Aire. «Optimizar el rendimiento y ser capaces de operar a gran velocidad. Esa inversión en nuestro programa de aviones de combate colaborativos es lo que nos va a llevar hasta ahí».

Allvin explicó que el rápido desarrollo de aviones no tripulados que actúan como copilotos de los cazas de 6ª generación, conocidos como Collaborative Combat Aircraft, representa la vanguardia de los equipos tripulados y no tripulados.

Algo similar está ocurriendo en el Ejército de Tierra, donde el «Project Convergence» aprovecha la informática basada en IA para «truncar» la curva sensor-tirador de 20 minutos a cuestión de segundos. Un sistema dotado de IA, por ejemplo, puede destilar cantidades ingentes de datos de sensores entrantes, hacerlos rebotar en una amplia base de datos y extraer conclusiones rápidas en términos de recomendación de un «tirador» óptimo a partir de datos de sensores sensibles al tiempo. El proceso de analizar una serie de variables diferentes en relación unas con otras y comparar circunstancias específicas con precedentes históricos puede tener lugar en cuestión de segundos o milisegundos cuando lo realiza un sistema con capacidad de IA. Todas estas funciones analíticas y de procedimiento pueden llevarse a cabo sin necesidad de decidir sobre el uso de la fuerza letal. Esencialmente, todos los análisis, procedimientos interpretativos y procesamiento de datos pueden ser realizados por ordenadores casi instantáneamente, dejando la decisión final sobre la fuerza letal a un ser humano.

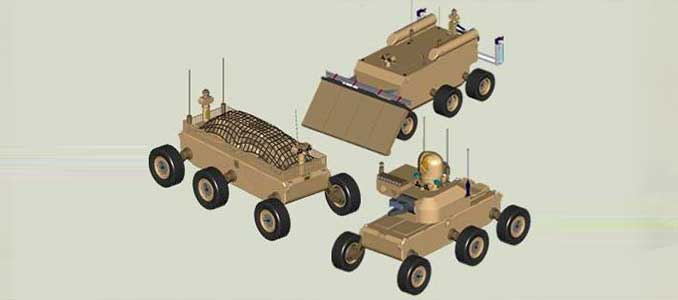

Robot autónomo MULE del Ejército

Ya en 2009, por ejemplo, el Ejército de EE.UU. se aseguró de consolidar su enfoque doctrinal al desarrollar el vehículo Multi-Utility Logistics Equipment, un robot armado con misiles antitanque Javelin y propulsado por lo que entonces se denominaba Sistemas de Navegación Autónoma (ANS). Ya en 2009, la tecnología para que un sistema robótico, armado con misiles antitanque, rastreara y destruyera un objetivo enemigo era inminente, si no estaba ya. Como resultado, los mandos del Ejército se esforzaron por revisar y consolidar la doctrina para garantizar que el requisito de «humanos en el circuito» se reforzara por completo. Aunque el MULE fue finalmente cancelado, el progreso tecnológico que permite mayor autonomía ha progresado a la velocidad del rayo hasta el punto de que ahora puede realizar una gama mucho mayor de funciones a velocidades mucho más rápidas y con mucho más análisis.

«¿Inteligencia artificial para la defensa?

Como parte de esto, la creciente exactitud, precisión, volumen y velocidad de los análisis basados en IA han llevado a algunos desarrolladores de armamento del Pentágono a explorar la aplicación de la autonomía «fuera del bucle». Esto significa que, por ejemplo, las armas con IA podrían funcionar bien y salvar vidas cuando se empleen con fines puramente «defensivos». ¿Quizás se podrían reconocer, identificar y destruir en cuestión de segundos morteros, cohetes, artillería o ataques de drones sin necesidad de recurrir a la fuerza letal? ¿Quizás se podrían disparar interceptores y destruir instantáneamente las amenazas mediante IA y armas defensivas? Aunque esta perspectiva introduce complejidades y, por supuesto, preocupaciones sobre su imprecisión, la posibilidad es algo que podría salvar vidas y marcar la diferencia en la guerra. El uso de armas «defensivas» habilitadas para la IA, si se protegen adecuadamente, concuerda con el mensaje clave de Kendall de que «no» emplear la IA simplemente significa que se perderá la guerra.

Fte. Warrior Maven (Kris Osborn)

Kris Osborn es Presidente de Warrior Maven – Centro para la Modernización Militar. Antes, trabajó en el Pentágono como experto altamente cualificado en la Oficina del Subsecretario del Ejército para Adquisiciones, Logística y Tecnología. Osborn también ha trabajado como presentador y especialista militar en antena en cadenas de televisión nacionales. Ha aparecido como experto militar invitado en Fox News, MSNBC, The Military Channel y The History Channel.