En 1787, el filósofo inglés Jeremy Bentham tuvo la idea de crear una prisión que costaría una fracción del costo de otras cárceles contemporáneas para funcionar sin prácticamente ningún delito interno. Su prisión teórica, el panóptico, era curva, las celdas orientadas hacia adentro, hacia un punto central donde se erguía una torre de guardia. Las ventanas de la torre de guardia debían oscurecerse. De esta manera, un solo guardia podría observar el comportamiento de todos los presos. Pero lo que es más importante, estos nunca sabrían si el guardia tenía su mirada puesta en ellos. El resultado final, cada individuo dentro de la prisión interioriza una sensación de estar vigilado todo el tiempo y se comporta en consecuencia.

Esta idea del panóptico se ha convertido en un sustituto de la amenaza de la vigilancia ubicua, debido principalmente a la elección de Bentham como escenario: una prisión. Pero Bentham no pretendía asustar a la gente, sino proporcionar una forma de gestionar un recurso escaso: la atención de las fuerzas del orden.

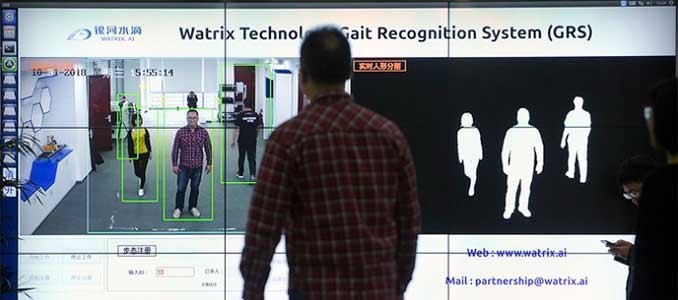

Una nueva tendencia en la tecnología de videovigilancia está convirtiendo en realidad el panóptico de Bentham, pero no de la forma que él se imaginaba. En lugar de una prisión, el nuevo panóptico centraría la atención de las fuerzas de seguridad en una persona cuando su comportamiento se vuelve relevante para la torre de vigilancia. Imagínese que fuera posible reconocer no las caras de las personas que ya habían cometido crímenes, sino las conductas que indicaban que un delito está a punto de ocurrir.

Múltiples proveedores y empresas que asistieron a la ISC West, una reciente conferencia de tecnología de seguridad en Las Vegas, buscaban suministrar a un mercado creciente de equipos y software de vigilancia que puedan encontrar armas ocultas, leer las matrículas de los vehículos y otros indicadores de identidad, incluso descifrar el comportamiento humano.

Una compañía llamada ZeroEyes de Filadelfia comercializa un sistema para los departamentos de policía, que puede detectar cuándo una persona está entrando en una instalación determinada portando un arma, que se integra en cualquier sistema de vigilancia de circuito cerrado.

Pero los algoritmos de aprendizaje automático no surgen sabiendo reconocer un arma de fuego como lo hace un perro que llega del criador sabiendo la diferencia entre la marihuana y el orégano. Para enseñar al algoritmo, un equipo de la compañía se presenta en el lugar y procede a escenificar ataques simulados. Poco a poco, el algoritmo comienza a aprender cómo se ve un arma en esa configuración específica, dependiendo de la luz, los ángulos y otras condiciones. Actualmente están trabajando con las escuelas de la ciudad de Nueva York, mediante un contrato con la U.S. Customs and Border Patrol, aunque aún no están desplegados en la frontera, dijo Kenny Gregory, un ingeniero de software de la compañía.

La detección automática de armas de fuego sería una solución a un problema creciente que no tiene una cura política clara: frenar los tiroteos masivos y la violencia armada. Algunas encuestas muestran que el 70 por ciento de los estadounidenses apoyan leyes más estrictas sobre armas de fuego, pero esa cifra es mucho menor, alrededor del 31 por ciento, entre los conservadores. Y así, el debate político, aunque acalorado, se ha estancado. Los algoritmos de detección de armas que alertan al personal de seguridad cuando llega una persona armada podrían reducir el número de víctimas, aunque es probable que no tanto como si no hubiera tiradores armados.

Se trata de un indicador predictivo de violencia potencial, en lugar de un indicador a posteriori, como el reconocimiento facial, y conlleva menos carga política. Cada vez más, las ciudades y los departamentos de policía están experimentando con el reconocimiento facial para detectar la presencia de sospechosos en tiempo real, pero están encontrando una fuerte resistencia entre los defensores de la privacidad en San Francisco y en otros lugares, donde algunos legisladores están tratando de bloquear su despliegue.

Sin embargo, los dos indicadores juntos, la identidad de alguien que está en una base de datos criminal y la presencia de un arma en sus manos, proporcionarían una probabilidad mucho más exacta y se reducirían los falsos positivos. En lugar del reconocimiento facial, algunos departamentos de policía confiaan en los lectores automáticos de matrículas como un indicador de identidad. Una compañía llamada Reconyx vende un sistema que puede leer automáticamente las matrículas y tiene múltiples clientes de las fuerzas de seguridad. La lectura automática de matrículas es un tema en que los defensores de la privacidad convencieron a un juez de Virginia para que limitara su uso por parte de los departamentos de policía.

Pero los esfuerzos políticos para restringir el uso de la inteligencia artificial en la vigilancia son mucho más lentos que la propia tecnología.

El reconocimiento mecánico de caras o matrículas es un tema de preocupación en cuanto a la privacidad, ya que se refiere a la identidad. Pero cualquier número de flujos de datos pueden indicar lo mismo. Se incluyen datos biométricos como la marcha o el habla, que pueden ser accesibles a través de flujos de vídeo, o incluso patrones de localización, que son detectables a través del teléfono móvil. Está una de las razones por las que usted podría ver un conjunto de anuncios totalmente diferente dependiendo de dónde se encuentre. Los proveedores de telefonía móvil y otros «anonimizan» nominalmente estos datos antes de enviarlos a terceros, pero los estudios muestran que las técnicas de anonimato pueden revertirse fácilmente comparando múltiples conjuntos de datos.

La presencia de un objeto específico, como un arma, en una persona específica, como alguien que está en una base de datos criminal, sirve como un indicador imperfecto de violencia. El futuro de la predicción de la violencia puede descansar en la recolección de otros datos relacionados con el comportamiento. En este campo, una startup, financiada por Peter Thiel, llamada Athena Security, se está distinguiendo entre las empresas que realizan reconocimiento facial y de objetos.

Athena vende software que puede reconocer comportamientos específicos, como pelear, caminar lentamente cuando otros están caminando rápido, prácticamente cualquier cosa que se aparta de la norma.

El software puede detectar que una pelea está a punto de ocurrir milisegundos después de que se lance el primer golpe, antes incluso de que el agresor se lance sobre la víctima. «Estamos calculando la velocidad de un puñetazo», dijo el fundador y director técnico de la compañía, Chris Ciabarra.

Athena puede combinar eso datos de otros puntos, como la expresión facial de los participantes en la interacción, para determinar el estado de ánimo e incluso la intención.

«Con el comportamiento, estamos viendo las emociones en su cara. ¿Están enojados? ¿Están tristes?», dijo.

Pero Athena también hace reconocimiento de objetos, como armas. Dicen que no necesitan desarrollar modelos in situ. El sistema funciona de manera similar a como lo hace el cerebro. Cuando detecta una anomalía, se centra en ella, y luego vuelve a sopesar los datos para alcanzar un mayor nivel de confianza. «Tan pronto como pensamos que hemos encontrado un arma, nos detenemos. Hace zoom en nuestra próxima imagen detallada para la computadora», dijo Ciabarra. «Si hay un arma, boom, la conseguimos. Ayuda a deshacernos de todos nuestros falsos positivos. Lo entrenamos de la forma en que un ser humano lo miraría.»

También están pasando a imágenes térmicas, para detectar armas ocultas. Y están reivindicando una tasa de éxito del 99 por ciento. La única limitación es la cámara; las cámaras de mayor resolución les permiten alejarse más. Pero la actividad de predicción es la misma.

Además, dice Ciabarra, funciona con prácticamente cualquier comportamiento detectable por la cámara que se quiera ver y predecir. «Nuestros clientes nos dicen -‘Tengo esta necesidad, quiero saber cuándo alguien hace algo’. Podemos construir eso para ese alguien», dijo.

En esencia, si es un comportamiento que los humanos pueden observar, también se puede entrenar a una máquina para que lo observe. Ciabarra dice que la compañía está hablando con la Fuerza Aérea y otros compradores del gobierno, pero donde está encontrando más interés es entre las compañías de Fortune 500.

China también quiere desempeñar un papel cada vez más importante. Cerca de dos docenas de empresas chinas estuvieron en la exposición vendiendo cámaras y software de seguridad. Un representante de la industria de la delegación china, que pidió permanecer en el anonimato, dijo que cada vez más fabricantes chinos de equipos de vigilancia buscan añadir valor a su oferta de productos ofreciendo software de inteligencia artificial para el reconocimiento facial o de armas.

El reconocimiento de la conducta anormal es también un área en la que existe un creciente número de estudiosos chinos.

Realmente no existe ninguna barrera legal para recopilar datos de vídeo sobre el comportamiento humano en entornos abiertos o públicos. Las cámaras de luz roja lo hacen todos los días dentro de los límites de un comportamiento muy específico. Pero la posibilidad de abarcar prácticamente toda la actividad humana que pudiera observarse y luego separar lo normal de lo anormal, crea un nuevo dilema para los defensores de la privacidad en Occidente. Un factor determinante de este dilema será el coste de los falsos positivos. Si ese coste -tanto para el individuo observado como para el observador- toma la forma de caros casos legales, detenciones injustas, etc., es probable que aumente el rechazo público a la vigilancia de la conducta. Si el coste del falso positivo se limita a unas pocas preguntas, o, tal vez, sólo una segunda mirada de una pieza diferente de software de aprendizaje automático, entonces es más fácil imaginar la aceptación pública de la vigilancia del comportamiento, especialmente a medida que la tasa general de falsos positivos disminuye.

Parecería que Bentham estaba siendo demasiado conservador cuando imaginó el futuro de la vigilancia, pues es posible crear, no sólo un sentimiento colectivo de estar siempre vigilado, sino también la realidad de ello.

Fte. Defense One